Tabla de Contenidos

ToggleEl mundo del SEO ha sufrido una sacudida importante después de que Google eliminara el parámetro de 100 resultados por página en sus páginas de resultados. Este cambio, aplicado sin ningún comunicado oficial ni previo aviso, ha alterado el funcionamiento de múltiples herramientas SEO como Ahrefs, Semrush o Kurranker, y ha afectado también a las métricas dentro de Google Search Console.

En este artículo, desde Daimatics, analizamos este cambio en profundidad, desde sus causas hasta las consecuencias prácticas para los profesionales del marketing digital y el posicionamiento web.

¿Qué parámetro ha eliminado Google y por qué era tan importante?

El parámetro en cuestión es &num=100. Éste se añadía a la URL de los resultados de búsqueda de Google para cargar hasta 100 resultados por página, en lugar de los 10 habituales. Gracias a este parámetro, herramientas de SEO como Ahrefs o Semrush podían recabar información sobre el Top 100 de resultados con sólo una sola carga por keyword.

Con su eliminación, estas herramientas deben realizar 10 veces más consultas para obtener la misma información, lo que supone un aumento de recursos, costes y tiempo de análisis.

“Este cambio obliga a las herramientas SEO a repensar completamente la forma en que rastrean y procesan los datos SERP. No es sólo un tema técnico: cambia la accesibilidad a la información.” - Equipo de consultores SEO de Daimatics

Pero más allá del sector de las herramientas, el impacto también ha llegado a los profesionales del SEO y propietarios de webs, especialmente en la forma en que se interpretan los datos dentro de Search Console.

Impacto directo sobre Google Search Console: impresiones y posición media alteradas

Tras el cambio, se han detectado dos comportamientos principales y recurrentes en las gráficas de rendimiento de Search Console:

- Un bajón notable de impresiones, incluso en webs con tráfico estable

- Un incremento repentino de la posición media

Para entender esto, es necesario saber cómo se cuenta una "impresión" en Search Console. Hasta ahora, si tu página aparecía en cualquiera de las 10 páginas iniciales (posiciones 1 a 100), aunque estuviera en la posición 95, se contaba como una impresión gracias al parámetro eliminado.

Ahora, sin este parámetro, sólo se cuentan como impresas aquellas URLs que realmente se muestran en los resultados visibles por defecto (Top 10 a Top 20, dependiendo del comportamiento del usuario).

"No es que tu web haya perdido tráfico real, sino que ahora Google sólo contabiliza lo que es realmente visible por los usuarios humanos, no por bots." - Analista SEO de Daimatics

Tabla comparativa: antes y después del cambio

| Aspecto | Antes del cambio | Después del cambio |

|---|---|---|

| Resultados visibles por página | Hasta 100 (con el parámetro) | Sólo 10 por página |

| Impresiones registradas | Hasta posición 100 | Sólo posiciones reales visibles |

| Posición media | Menor (efecto de datos hinchados) | Mayor (más realista) |

| Acceso a datos SERP | Fácil y económico para herramientas | Costoso y limitado |

Reacción de las herramientas SEO: cómo se adaptan Ahrefs, Semrush y Kurranker

Ahrefs

El CEO, Tim Soulo, ha preguntado a la comunidad SEO si realmente es relevante seguir conociendo las posiciones 30, 60, 90. Él argumenta que quizás estas posiciones no aportan valor real y sólo derrochan recursos.

Sin embargo, muchos expertos SEO —incluyendo nuestro equipo— discrepan parcialmente. En proyectos nuevos o en etapas de escalado, es fundamental ver en qué punto entra tu web dentro del universo semántico de una keyword, aunque sea en la posición 70.

Semrush

Su respuesta ha sido más ambigua. Aseguraron que el Top 10 continuará mostrándose de forma constante y que el Top 20 se actualizará con menor frecuencia (hasta 48 horas). Sobre las posteriores posiciones, no han concretado su estrategia técnica.

Kurranker

Esta herramienta ha sido muy directa: por ahora, sólo ofrecerá datos hasta el Top 20. Están trabajando en una nueva solución que permita volver a rastrear hasta el Top 100 de forma sostenible.

¿Google lo ha hecho expresamente para bloquear scrapers y IA?

No existe ningún comunicado oficial de Google, pero todo indica que sí. Esta decisión forma parte de un movimiento estratégico para reducir:

- El uso masivo de bots y scrapers para monitorear posiciones SEO

- La extracción de datos por sistemas de inteligencia artificial (como ChatGPT, Perplexity o Gemini)

De hecho, en las Directrices contra elspam de Google, se establece que rastrear resultados de búsqueda con bots está explícitamente prohibido y puede interferir con su aprendizaje automático.

Quality Raters y AI Overview: nueva era para el SEO

Google ha actualizado las pautas de sus Quality Raters para incluir la evaluación de respuestas generadas por IA dentro de AI Overview. Estos evaluadores ahora deben determinar si la respuesta:

- Es correcta y objetiva

- Es relevante para la intención de búsqueda

- Es suficientemente completa

Un ejemplo concreto: si la IA responde a una pregunta con información dispersa y sin un dato claro, ésta será considerada una respuesta incorrecta.

¿El AI Mode será la búsqueda predeterminada? Google se contradice

Logan Kilpatrick, jefe de producto de AI Studio, afirmó a X que el Modo IA será el sistema de búsqueda por defecto próximamente. Sin embargo, Roby Stein (product manager de Google Search) lo desmintió o, al menos, restó importancia a las declaraciones de su compañero.

Según datos de SimilarWeb:

- Sólo el 3% de los usuarios en EE.UU. utilizan AI Mode

- El 3,5% lo hacen en Reino Unido

Por tanto, el uso de la búsqueda potenciadas por IA es todavía anecdótico, pero habrá que seguir su evolución.

La publicidad en la web abierta está en declive: lo reconoce Google

En un entorno judicial, Google ha reconocido que la publicidad display está en decadencia en la web abierta. Esta afirmación choca con el discurso positivo mantenido hasta ahora por sus directivos, incluido Sundar Pichai.

"La web abierta se está debilitando. La gran concentración de tráfico y la competencia de otras plataformas han afectado al modelo publicitario clásico." — Google (declaración en caso antimonopolio)

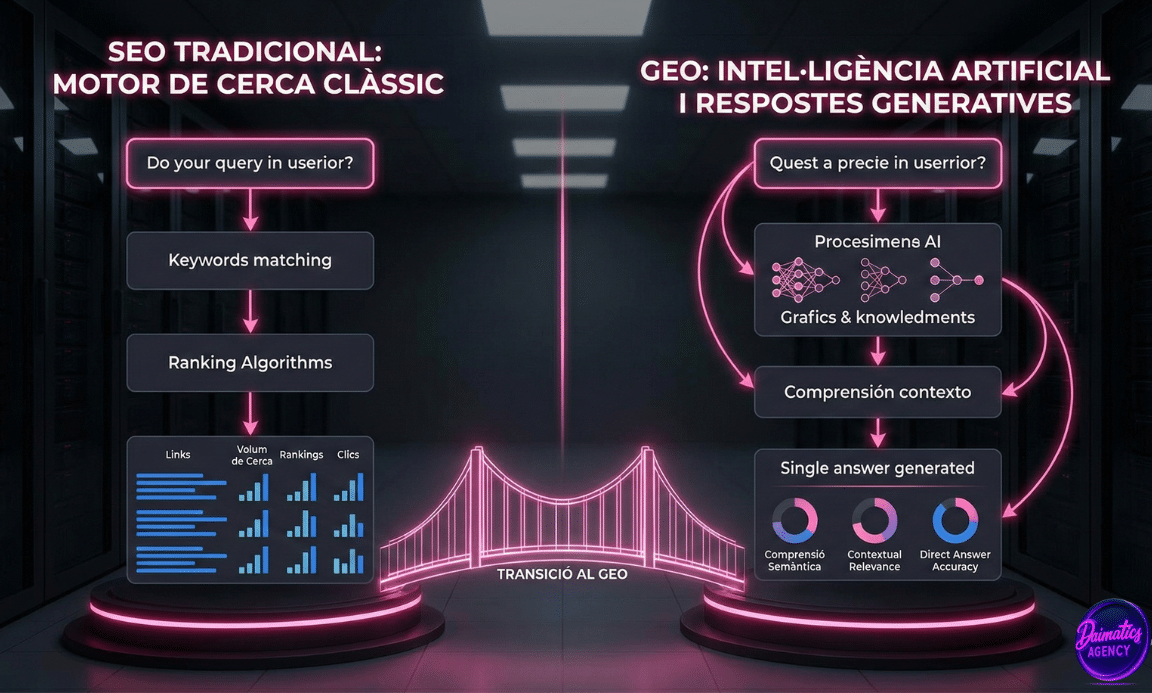

GEO, LLM Optimization, AI SEO... ¿qué decimos ahora?

Una encuesta de Search Engine Journal muestra que la comunidad SEO se divide a la hora de nombrar a esta nueva disciplina:

- 36%: AI Search Optimization

- 27%: SEO para IA

- 18%: GEO, LLM Optimization y otros nuevos términos

En Daimatics seguimos apostando por una visión clásica del SEO adaptada a las nuevas reglas del juego. Con datos estructurados, reputación digital y enfoque en la calidad.

Conclusiones: una nueva etapa para el SEO

La desaparición del parámetro de los 100 resultados es algo más que un detalle técnico. Es un cambio de era en el acceso a la información SEO. Las herramientas tendrán que reinventarse, los SEOs tendrán que afinar mejor sus estrategias, y Google cierra cada vez más su ecosistema.

Pero no todo son problemas. Los datos serán más precisos, las estrategias más centradas, y el enfoque cada vez más orientado a la calidad real, no a volúmenes hinchados.

Si quieres adaptar tu estrategia a este nuevo escenario SEO, contacta con Daimatics y te ayudaremos a orientar tu proyecto con datos reales y estrategia efectiva.

❓ Preguntas frecuentes sobre el cambio del parámetro de Google

Es un parámetro de URL que permitía ver 100 resultados por página en los SERPs. Google le ha eliminado para dificultar el scraping masivo.

Porque ahora sólo cuentan las impresiones reales visibles en el top 10, no hasta la posición 100 como antes.

No. Afecta cómo se miden y cómo se ven los datos, pero no la posición real en los resultados de Google.

Ahrefs, Semrush, Kurranker y otras herramientas de rastreo masivo que dependían de ese parámetro.

Optimiza por calidad, estructura tu contenido, mejora citas, y apuesta por la relevancia en IA y datos estructurados.